A au fait maman merci pour le conseil.

Ah oui lequel ?

Ouvrir l'assurance vie carac et par une patrimoine ?

Ah oui.

En 2024, le fonds euro de la carac m'a rapporté 3,50%.

Mais oui la carac s'occupe bien de nous et depuis longtemps.

Et nous avons un conseiller en patrimoine dédié qui change tout.

Et jusqu'au 31 mars, la carac me donne 50 euros si je verse 2000 euros.

Et ça peut aller jusqu'à 1000 euros offert.

A la carac, on se bat pour vous.

Les taux passés ne préjuchent pas des taux à venir.

Taux net de frais avant prélèvement sociaux.

Offre soumise à conditions, plus d'informations sur carac.fr.

Mutuelle soumise au livre 2 du code de la mutualité.

Je crois que c'est bon.

Tout le monde sait que les IA de génération d'images

ont atteint un niveau stratosphérique.

Les gens confondent, on a du photoréalisme,

on sait plus le réel, le faux.

Ok ça c'est bon.

Vous avez peut-être également vu des images de génération de vidéos.

Paria.

Je sais pas si vous en avez déjà vu.

Euh oui.

Ça commence à arriver un peu doucement.

Ça se fait discret mais vous avez peut-être vu des démonstrations à droite à gauche.

Moi aussi j'ai vu ces démonstrations depuis plusieurs mois.

Je suis ça de très très près.

Et en fait ça m'a donné des idées.

Parce que c'est beau de montrer des démos,

des trucs faits par d'autres gens etc.

Mais il y a un moment, je pense qu'il y a beaucoup de gens qui voient tout ça,

qui se disent ok en fait.

Mais comment ça pourrait être utile,

moi dans ma vie de tous les jours ?

Genre comment je transforme cette démo sexy de Twitter

en quelque chose de réellement utile ?

Pour moi ou pour ma boîte ?

C'est exactement la question que je me suis posée.

Et je vais vous montrer un outil

sur lequel je travaille depuis deux semaines

que j'ai concocté.

Et je pense qu'il va rendre jaloux beaucoup de monde.

Y compris beaucoup de Youtubers.

Puisque c'est un outil pour accélérer énormément

et démultiplier le potentiel d'une vidéo en termes d'illustration.

C'est un casse-tête qu'absolument n'importe qui dans la vidéo se pose constamment.

Mais comment c'est, comme on fait en sorte de rendre notre histoire,

notre vidéo la plus engageante et la plus visuelle possible ?

Avec plein d'images, vous savez, le rythme s'est accéléré sur Youtube,

il y a maintenant un standard en termes de qualité d'illustration de fou.

Le problème des générations d'IA etc.

C'est que c'est un peu statique.

Tu as table, l'animé, faire des trucs.

Ça restera juste une image très flatte et un peu ennueuse.

Et du coup, il y a un potentiel avec les IA generatives de vidéos.

Mais elles sont pas parfaites.

Vous allez voir, je vais vous montrer, il y a pas mal de problèmes.

Mais en fait, on peut souvent les contrôner en étant un peu malin.

Et je vais vous montrer tout ce que j'ai imaginé pour essayer de faire un outil de A à Z

qui permet en fait, l'objectif final, c'est que en 30 secondes,

juste en lisant le simple script d'une vidéo,

l'outil sera capable de générer de A à Z des dizaines et des dizaines

d'illustrations ultra contextuelles et magnifiques pour le menteur.

Le but n'étant pas de complètement enlever la partie montage,

mais plutôt de démarrer n'importe quel montage avec une base d'assets

ultra-calie qui vont pouvoir agrémenter toute la vidéo

et sublimer finalement l'histoire.

Mais c'est des images statiques, du coup, c'est pas des vidéos.

Bah si, justement, ce sera des vidéos.

OK.

C'est ça.

Je me souviens de le voir.

Parce qu'en fait, ce que je viens de décrire,

tu peux le faire déjà avec mid-journée en statique.

Tu peux générer avec une API ou des trucs comme ça,

générer 50 images qui parlent à peu près de ton sujet.

Là, c'est pas ce que je cherche.

Moi, je veux de la vidéo en très haute qualité et qui bouge.

Voilà, tout simplement.

Et vous allez voir, c'est pas si évident.

D'abord, je vais vous montrer quelles sont les IA actuelles,

qui sont les plus intéressantes, pour vous fassir un peu une idée de

qu'est-ce qu'on peut atteindre comme niveau de qualité.

Alors, la première boîte qui a beaucoup fait parler,

elle s'appelle Runway.

C'est celle, à mon avis, si vous avez vu passer des démos,

c'est ça que vous avez vu.

Donc, il y a eu la première génération, Gen 1,

et la Gen 2 qui a arrivé à peu près cet été,

et qui a étonné tout le monde parce que le progrès qu'on a fait

en trois mois est juste hallucinant.

Quand même, quand tu compares au progrès qu'on a fait en images,

on s'attendait à avoir encore des années à attendre

avant d'avoir de la vidéo qui était active.

Et Gen 2 est arrivé.

Et je vais vous montrer, pour vous démontrer le potentiel,

un trailer qui a été fait par un fan de Star Wars.

Tout le monde aimerait finalement voir qu'elle serait le Star Wars du futur.

Une nouvelle histoire qui n'a encore jamais été écrite par George Lucas, etc.

Et bien, cette personne, toute seule depuis sa chambre,

c'est extrêmement cliché cette phrase, mais c'est le cas,

a imaginé son trailer de rêve pour un Star Wars.

Il l'a fait entièrement avec intelligence artificielle.

Si tu peux le mettre en grand-tile, si tu peux,

avec le son, ce serait parfait.

Non mais sur l'autre scène, évidemment.

Merci.

On n'a pas le son.

Viste.

Rien qu'image.

C'est ça.

C'est quand même...

Ah, on voit des fois les petits...

Oh !

On remet le début.

On remet le début ?

Oui, oui, oui.

C'est bon, mais tu vas concentrer.

Donc ce trailer a été entièrement généré.

Il n'y a quasiment pas de post-processing.

Oh, il y a des bonhommes.

Ah yes.

C'est cool, hein ?

C'est cool.

Waouh !

C'est très très cool.

Je demande lui-même limite un peu moins que sur les vrais trailers.

Non.

Mais oui, mais c'est fascinant.

Et surtout, vous avez peut-être remarqué,

il y a quand même des parfois...

On voit qu'il y a des petits traits qui bougent.

Il y a les sabres laser qui ne sont pas parfaits à un moment.

Mais c'est quand même super.

Ou alors, les corps, c'est-à-dire que

des très gros plans marchent bien,

mais dès que tu as une personne en entier,

souvent ça démarche, il y a un peu étrange.

Et donc c'est pour ça que lui, il joue avec ses limites

en faisant énormément de plans saccadés.

Et donc, voilà, toutes les 4 secondes en rythm avec la musique,

ça marche trop bien.

Ça marche pour un trailer, quoi.

Exactement.

Alors ça, il faut dire que quand même,

il y a beaucoup de travail manuel de sélection.

C'est-à-dire qu'il va faire 10 générations avec Gen2.

Et même la manière dont marche ce générateur de vidéo,

c'est que tu as un peu de contrôle sur ce qui se passe.

Donc tu peux orienter la caméra par exemple.

Tu peux dire, ok, la caméra devrait faire un desoom,

ou un zoom, ou un droit, ou un gauche.

Ou alors tu peux sélectionner des zones

où tu as un genre de pinceau et tu lui sélectionnes une zone

et tu lui donnes une direction.

Donc, exemple, tu as un volcan qui explose, qui est rupte.

Et bien tu vas pouvoir avec ton pinceau,

sélectionner la partie qui est rupte,

et le dire, va vers le haut.

Et du coup, ça aide Lia

à avoir pile le bon mouvement sur le...

Très cool.

La lave qui monte comme ça.

Peut-être qu'elle aurait le viner, mais peut-être pas.

Donc en gros, ça te donne un niveau de contrôle supplémentaire.

Mais le problème, c'est que c'est manuel.

Du coup, ça demande du travail manuel.

Tu as automatisé toi.

Vous allez voir que pour mon problème, après,

ça me roge pas.

Mais il faut surtout se dire que ça,

c'est quand même une sélection de très peu de générations

sur énormément de tentatives.

Si on regarde de manière plus réaliste,

un autre...

enfin d'autres exemples qui sortent de

de Gen 2, ça ressemble plutôt à ça.

Donc ça, c'est des compilations

que j'ai trouvées sur YouTube, c'est à dire 45 minutes.

Elles sont géniales.

Globalement, c'est plein, plein, plein d'exemples de vidéos

qui sortent de Gen 2.

Donc là, on voit du hacheline.

Il y a toujours un petit côté creepy.

Moins qu'avant quand même.

Mais tu as quand même des trucs un peu bizarres parfois.

Ça, ça me fait plus creepy que...

Oui, oui.

Même parfois, c'est étrange.

Mais globalement, ce qu'on peut voir,

c'est que sur les animaux, ils galèrent un petit peu quand même.

Sur les mouvements de...

Enfin, en général, il va faire bien des mouvements de...

Oh, c'est...

Oh, c'est très ppsiqué là.

Je me demande dans quel contexte les gens regardent ça.

J'ai une petite idée.

J'ai une petite idée globalement, mais...

Mais à mon avis, il y a des fins de soirée qui se passent.

Après, vous, ça, le hacheline du tube est assez spécifique.

T'es au fin fond de la soirée, là.

Oui.

Et tu vois que parfois, il fait des hallucinations.

Donc, ça veut dire qu'il a cru un moment que l'épaule, c'était une tête.

Du coup, il a créé une double tête, un genre de cerberre.

Bref, donc tout ça pour dire que...

Je suis en train de partir là.

Tout ça pour dire que globalement,

c'est moyennement qualitative.

C'est ça qu'il faut comprendre.

Il faut pas mal de générations pour arriver à de la qualité.

Et du coup, pour palia ça,

notamment tout ce qui concerne les mouvements naturels de Danimo,

il y a d'autres gens qui ont proposé des IA concurrentes.

La dernière qui est sortie, elle s'appelle La Vie.

À mon avis, c'est probablement parce qu'elle est très forte

à dessiner des images de Danimo ou d'Humain.

Et donc à imiter des mouvements de vie organiques.

Mais peut-être moins des caméras, vous allez voir justement.

C'était annoncé dans un tweet.

Et en gros, les principales distinctions,

c'est que là où pour Gen 2, etc.,

ça marche tout seul, t'as quasiment rien à dire.

Là, tu vas devoir décrire le mouvement.

Donc si tu peux montrer le formulaire,

en gros, t'accès à quelques options comme toujours,

avec ces modèles-là.

Tu vas pouvoir demander un certain nombre d'images par seconde.

Donc tu vois ton image, elle soit en 6 ou en 25 fps.

Et tu vas pouvoir mettre un prompt.

Donc décrire quelle action tu voudrais que ton panda y fasse.

Donc ici, un panda qui parle en mode selfie, haute qualité, machin.

Donc c'est un peu le même fonctionnement que sur les mid-journées qu'on connaît,

mais appliqué à la vidéo.

Et donc on imagine qu'une version ultra aboutita,

ça permettrait de lui faire faire des actions non prévisibles.

Par exemple, si tu veux qu'il se mette debout et qu'il danse la polka,

on imagine qu'il faudrait un système de prompt aussi

que les IA dont je vous ai parlé avant, non pas.

Donc ce serait peut-être plutôt ça, en fait,

l'IA du futur qui génère de la vidéo.

Là, la output, c'est une vidéo,

enfin, on dirait un GIF.

On dirait un GIF.

Alors pourquoi on dirait un GIF ?

Alors que c'est une vidéo.

Parce qu'en fait, un GIF, c'est juste une vidéo avec peu de frame.

Exactement.

Là, la raison pour laquelle ça seure seulement en mode GIF comme ça,

c'est qu'il y a peu de frame en réalité qui sont produites.

Ok.

Ce que ne nous dit pas le Gen2 Runway,

c'est qu'en fait, ils font du post-processing pour tricher.

À pour fluidifier le mouvement entre les frames.

La plupart des générateurs de vidéo,

en réalité, il faut imaginer que c'est des générateurs d'image,

type mid-journée-compagnie,

mais avec une dimension en plus.

Plutôt que de simplement gérer une matrice de pixel,

il faut imaginer une dimension supplémentaire

où ils doivent imaginer le mouvement.

Ils font de la prédiction de mouvement.

Donc ça veut dire que eux, dans leur training,

ils doivent avaler des quantités et des quantités de petites vidéos

qui font en général quelques secondes.

On n'arrive pas à aller plus loin que ça,

c'est déjà incroyable, en vrai.

Ça fait en général quelques secondes.

Et du coup, il faut le voir comme,

c'est comme si il devait apprendre un cube

au lieu d'apprendre une matrice, en fait.

Et donc chaque image fait partie de la même génération.

C'est pas juste qu'ils lancent mid-journée plein de fois d'affilée.

On a vu pas mal de tentatives qui faisaient ça dans stable fusion,

mais ça marche pas très bien globalement.

La cohérence, elle part totalement et ça fait des trucs psychédéliques.

Donc là, la nouvelle approche est de vraiment générer

toute la séquence d'image en un seul coup, en fait.

Et c'est ça qui donne de la cohérence dans les mouvements.

Et c'est assez facile de voir que, suivant tel ou tel objet,

il a capté, en fait, d'une certaine manière, comment ça bougeait.

Tu vois un humain, bon, c'est pas hyper bien fait,

mais globalement, tu vois qu'il essaye de faire bouger les jambes,

et tout comme ça.

Tu lui donnes une fusée.

C'est dans l'exemple juste après.

Mais là, si on met les autres exemples de la vie que j'ai mis juste en souteau,

globalement, si tu vois une image,

il a compris que cette ours, c'est plutôt sa tête qui bouge.

Il a compris qu'il y a un chien, en général,

que derrière, elle a un mouvement de droite-gauche.

Là qu'un nounours, il est un peu humanoïde,

et donc, il doit avoir ses pieds qui avancent.

Donc tu vois, tu peux arriver là à lire qu'est-ce que l'il y a compris

en avalant toutes ces données.

J'ai vu de la neige qui tombait aussi,

et je pense qu'il allait du comprendre,

enfin sur celle d'avant.

Il a capté le...

Sur le sur celle du nounours, il y avait de la neige derrière, je crois,

si j'ai bien vu.

Précilé.

La patte.

En fait, quand tu imagines le smartphone, il est de côté, tu vois.

Donc, ça veut dire que lui, il a bien compris que c'était un rectangle.

Tu vois, il te génère la 3D, en fait.

Bref, tout ça pour dire.

Ça, c'est la vie.

La vie.

La vie, il est particulièrement bon à faire des trucs organiques,

donc typiquement des animaux qui bougent,

ou des humains, contrairement aux autres, qui galèrent un petit peu plus.

Le troisième modèle que je vais vous montrer,

théoriquement, il est moins impressionnant que les autres.

Et pourtant, c'est mon préféré.

Et vous allez vite comprendre pourquoi.

Il s'appelle Stable Video Diffusion.

Donc, c'est la même boîte qui fait Stable Division, qui l'a sortie.

C'est...

Attends, comment il s'appelle ?

Stability AI.

Qui vont sortir ça un peu après tout le monde.

Et ce qui est très intéressant avec celui-là, c'est que, comme souvent,

Stability AI, ils font des trucs open source,

donc n'importe qui peut télécharger,

et qui sont faits pour tourner sur du matériel d'utilisateur.

Donc, ils conçoivent pas leur modèle pour tourner sur des GPU à 125 000 euros.

C'est plutôt pour que ça tourne chez toi.

Donc ça, c'est quand même une propriété intéressante.

Et leur modèle, globalement, il est assez impressionnant,

parce qu'il a une très bonne consistance.

Il va souvent faire moins de mouvements.

C'est-à-dire que globalement, il va...

Tu vas voir 10 personnes, il va être moins inventif,

dont la manière dont elle pourrait se déplacer,

ce sera plus uniforme.

Mais si on regarde les exemples, vous allez voir que c'est très souvent réussi.

C'est-à-dire qu'il y a besoin de moins de générations,

pour que ça fonctionne.

Donc là, on voit une dame avec ses cheveux qui bougent.

Si t'en as...

C'est un côté électricité statique.

Salut !

Si vous appréciez UnorsCore, vous pouvez nous aider de ouf !

En mettant 5 étoiles sur Apple Podcast,

en mettant une idée d'invité que vous aimeriez qu'on reçoive,

ça permet de faire remonter UnorsCore.

Voilà.

Telle une fusée.

Oh la montagne, j'ai hâte de savoir ce qu'il va...

Tu vois, sur des scènes comme ça,

il va en général...

Enfin, il va pas te inventer une éruption sur le vol quand tu vois.

Un panoramique.

Exactement.

Elle va dire, oui, elle allait pas bouger.

Tu fais un panorama et il t'invente des droits de gauche.

Souvent, c'est plus qu'un pan de la caméra,

il va y avoir de la parallaxe entre un premier plan et un second plan.

Avec une personne, tu vois, elle n'a pas énormément bougé la dame,

mais c'était quand même relativement plausible.

Oui.

Et en gros, le patéan qu'on peut observer,

c'est que c'est pas genre hyper impressionnant,

mais c'est cohérent.

Et ça, moi, ça m'intéresse.

Oh, si quand même, moi je trouve ça un peu impressionnant.

Non, non, non, mais d'accord.

Là, je la trouve vraiment réaliste.

C'est très impressionnant.

Oui.

Ce que je veux dire, c'est qu'il va pas te inventer des trucs de fou,

ça va être subtil, mais plutôt très consistant.

Oui.

Et donc ça, c'est très intéressant pour moi,

parce qu'en gros, je préfère largement un truc qui marche,

enfin, qui marche bien tout le temps,

et qui n'est pas impressionnant,

qu'un truc qui me sort une dinguerie une fois sur ce, en fait.

Et le deuxième truc génial, en fait, de ce modèle,

c'est que, comme il est open source,

il y a des gens qui l'ont déjà très, très rapidement

déployés sur des services en ligne à la demande.

Pour faire simple, on peut l'automatiser comme des pas.

Et pour ça, j'ai utilisé un service qui s'appelle Replicaid.

Est-ce que vous avez déjà entendu parler de Replicaid ?

Moi, ça me dit un truc, mais alors je sais plus ce que c'est.

En général, les gens peut-être qui nous écoutent,

l'auront vu passer comme ça en testant des modèles.

Donc tu vas sur Replicaid.com,

et si tu veux montrer la homepage à quoi ça ressemble,

je t'ai mis un... Qu'est-ce que je t'ai fait ?

Si, si, oui, je t'ai mis une vidéo que j'ai enregistrée.

Donc si tu peux mettre ça en fullscreen, idealement.

Non, voilà, pas parfait parfaite.

Donc peut-être vous l'avez déjà vu passer en lançant un modèle au hasard,

vous avez vu un nouveau modèle d'IA, d'image ou d'audio,

et vous êtes arrivé sur une interface comme ça,

où en gros, vous avez le petit formulaire à gauche, la génération, etc.

Et peut-être que comme moi, au début, vous vous avez dit,

OK, cool, un logiciel pour générer des IA,

sauf qu'en fait, ce serait passé à côté de ce qui est dingue dans ce système.

Pour comprendre, il faut se mettre dans la tête d'un développeur

qui aujourd'hui, là, voudrait utiliser toutes ces nouvelles IA, super cool.

Quand t'es développeur et que tu veux te faire des inférences

sur des gros modèles d'IA qui tournent sur des GPU,

en gros, t'as le choix entre déployer ta propre infra,

donc ton data center,

ou ton ordi chez toi avec un GPU qui tourne à 24

et qui te coûte 400 balles par mois d'électricité.

J'allais dire, c'est cher.

Exactement.

Ou deuxièmement, louer une infrastructure,

donc par exemple, un serveur unique avec un GPU au mois.

Pour vous donner un ordre d'idée,

un serveur que tu dois louer au mois,

ça va coûter très facilement dans les 200, 300, 400 euros

pour des petits GPU pas extrêmement puissants.

Donc ça va vraiment très très vite.

La location de GPU au mois, c'est vraiment assez violent.

Et je me permets, ce que du coup je travaille chez un hébergeur,

en fait, c'est déjà parce que les cartes graphiques coûtent cher, évidemment,

mais c'est parce que c'est aussi très nouveau de louer des capacités fin.

Ça a quelques années, mais d'un point de vue cloud et hébergement, c'est très nouveau.

Avant, c'est juste des serveurs.

Il y avait un CPU, on se focalisait sur le CPU,

et parfois sur le disque dur, parfois la RAM et tout, mais jamais la carte graphique.

C'est un usage très nouveau et du coup, ça coûte cher

parce que ce n'est pas les mêmes cases, ça prend plus de place,

une carte graphique et tout, c'est chiant à intégrer dans les process industriels

et du coup, ça coûte cher.

Par exemple, j'ai vu des vidéos d'un Youtuber américain, Lineus Tech Tips,

qui essaient de faire rentrer des GPU dans des rack de unités.

Et c'est bête, mais en le voyant, je me suis dit,

ah bah oui, c'est pas assez évident en fait.

Bah oui, complètement.

Ce qu'on sait, c'est que dans les data centers, ce qui coûte cher, souvent, c'est la place.

Ah bah c'est tout est optimisé vraiment au col de cul.

Bon, maintenant, ils savent le faire, mais c'est nouveau, il y a des R&D derrière,

il faut rentrer à BZ, etc.

Et c'est notamment pour ça que les GPU entreprise de Nvidia sont beaucoup plus fins.

Mais beaucoup plus cher.

Oui, beaucoup plus cher.

Et c'est ce qu'on a le...

On parlera de Nvidia dans cette émission, parce qu'il y a des sujets à faire en vrai.

Et donc, voilà, ça coûte en gros dans les 200, 300, 400 balles très facilement.

Et ça part du principe que tu en aurais besoin tout le temps d'un stop.

Or, la plupart des développeurs, et nous, par exemple, ce dont on a besoin, c'est plutôt

quelques heures de temps en temps de faire tourner une inférence juste le temps qu'il faut.

Et après, je veux plus payer quoi.

Moi, je veux payer en gros, idéalement, à la minute, voire à la seconde.

Ça, c'est un nom pour les développeurs.

Tu me dis si je me le troupe.

Mais ça se appelle le serverless.

C'est le fait que tu possètes pas vraiment ton ordinateur, ton infrastructure, mais tu payes

vraiment à la minute à l'exécution de ta fonction.

Ça existe depuis longtemps sur des ordis normaux, mais ça n'existait pas du tout sur les GPU.

Vraiment, c'était une d'enri qui n'existait pas et que tout le monde attendait.

Jusqu'à ce que quelques acteurs pas très connus arrivent, notamment Replicate.

En réalité, le site de Replicate, là, avec sa jolie interface, c'est même pas le plus

intéressant dans la service parce que c'est un des tout premiers sites de GPU serverless.

Et ça, ce que ça ouvre comme possibilité, c'est que tu peux imaginer des algos qui

ne tournent pas en local sur ta machine, mais qui seront entièrement dans le cloud.

Et tu peux avoir à la fois 200 inférences en parallèle, donc générer 200 images en même temps,

et ne payer juste ce que tu as besoin.

Et après, toutes les instances, toutes les machines sont rendues à d'autres.

Et ça, c'est quand même magique, surtout pour ce dont moi, j'ai besoin juste après.

Moi, vous savez peut-être qu'un des trucs que j'aime bien utiliser pour faire des automatisations

dans la boîte, ça s'appelle N8N.

Donc c'est un logiciel avec des petites briques, tu peux envoyer le visuel.

C'est un logiciel avec des... Alors je me suis peut-être emmêlé dans les pinceaux.

Attends, attends, attends.

Euh... Si c'est bon, pardon, je me suis un peu emmêlé.

Mais tu peux l'envoyer, c'est l'automatisation dans N8N.

N8N, c'est une interface du coup d'automatisation.

Techniquement, c'est comme de la programmation, mais en nodale.

Vous avez des petits nœuds comme ça qui font des chargements, et vous pouvez imaginer

des algorithmes complets, mais juste sans coder, ou quasiment.

Exactement.

C'est un zappieur like un peu que tu peux héberger.

Exactement, que tu peux héberger exactement chez toi, et qui va coûter beaucoup, beaucoup moins cher

qu'un zappieur en général.

Et ce dont je me suis rendu compte, c'est que...

Y'a pas de nœud pour replicate.

Ça c'est chiant.

Je vois la scène, Mickael fait...

Ah non, ça c'est chiant.

Et du coup, j'ai dû développer un nouveau nod pour N8N.

Ah tu l'as fait ?

Ouais, du coup je l'ai fait.

C'est chronique, faire la pub.

Si vous avez besoin d'utiliser ça.

En vrai, sans rire, c'est incroyable.

Parce que déjà, le fait que N8N permette de...

Attends, on revient, je l'attue juste après.

Mais en gros, le fait que N8N permette, soit au peu de source,

ça permet comme ça de développer tes propres bics dont t'avais pas besoin.

Et là, juste, en un week-end, en fait,

grâce à ça, je me suis créé le petit nod,

que tu peux remontrer, pardon, je me suis créé le petit module,

qui permet de faire tourner n'importe quel IA de replicate,

qui est un site collaboratif.

Petite parenthèse, tu l'as codé en quoi ?

C'est du JS, c'est un du CNOD.

Et du coup, ce qui est merveilleux,

c'est que juste en créant ce nœud-là,

je me suis créé la possibilité

d'utiliser à peu près n'importe quel modèle,

n'importe quel IA de la plateforme, qui est communautaire.

Et même si jamais elle y est pas dessus,

c'est communautaire, donc je pourrais même publier mon propre modèle

avec un truc qui s'appelle Cog,

qui est leur outil pour faire des genres de petits conteneurs

ou tatons niacs, tu l'envoies comme ça dans le cloud.

Bon bref, ils font tout, c'est vraiment de la magie.

Et du coup, grâce à ça, j'ai pu utiliser replicate dans N8N.

Je me suis perdu, où est-ce que j'en étais ?

Pardon, il y a beaucoup d'iludes dans ma chronique, je suis désolé.

On alterne un peu entre tous.

Je vais reparler de N8N du coup,

pour vous montrer concrètement ce que j'ai imaginé.

Un des problèmes qu'on a avec...

Ah non, je me suis trompé, je te fais défolter.

Si il est là, on rigide, si il est là, on me le...

Si il est à la goutte de sueur...

C'est le moment de parler de topaz.

Un des problèmes que vous avez vu avec ces modèles,

qui est flagrant et qui empêche le fait qu'on puisse vraiment l'utiliser

nous pour des vidéos ou à grande échelle,

c'est que, comme tu l'as vu, il y a peu d'images.

Donc ça fait des gifs, c'est pas très beau, tu te dis,

non, il y a rien à en faire.

En fait, idéalement, ce qu'il faudrait, c'est un système

qui permet d'augmenter la résolution de tout ça

et de créer des images supplémentaires au milieu, tu vois.

C'est dommage, hein.

Ah, ce serait bien si ça existait.

Ça existe.

Ça s'appelle topaz vidéo AI

et c'est littéralement de la magie.

Si vous n'avez jamais utilisé ce logiciel,

ça tourne en local.

Donc ça veut dire qu'il n'y a pas de trucs à payer très très cher.

Il faut en général une carte Nvidia

pour que ça tourne très bien,

sur un PC gamer par exemple.

Et concrètement, vous allez pouvoir faire de l'upscaling de vidéos.

Donc prendre n'importe quelle petite vidéo

et la transformer en full HD 4K 8K

autant que vous voulez.

Ah oui, pas forcément pour n'importe quelle vidéo en fait.

Exactement. Nous, on l'utilise pour...

Exemple ?

Un score, par exemple.

Un vidéo a été upscaled si j'ai bien compris.

Exactement. On est en train de tenter

pour les vidéos de l'émission

de les upscales en sorties.

Donc une fois que le montage est fait, on les passe en 4K 60.

Donc si vous vous rendez compte que la qualité vient d'augmenter,

c'est pas qu'on achetait des meilleures machines,

c'est qu'on a utilisé de l'IA.

Vous nous direz si c'est bien, si ça fait bizarre,

c'est... voilà, on tente.

Et donc, ce logiciel magique

permet non seulement d'augmenter la résolution

mais aussi de créer des images.

Peut-être vous avez déjà essayé de prendre une vidéo

et de la ralentir.

Je ne sais pas, vous avez filmé quelqu'un de famille

et vous avez dit,

« Et si je faisais un slow motion

de ce super besoie à ski ? »

Et là, c'est le moment où tu te rends compte que

la vidéo, ça marche pas comme ça.

La vidéo, ta caméra, elle prend un certain nombre d'images.

Et si tu la ralentis trop, ça devient dégueulasse.

Par exemple, tu prends quelqu'un qui saute,

et il va avoir, je ne sais pas moi, 25 images dans la seconde.

Si tu essaies de la ralentir, ça devient imbuvable.

Mais, avec ceci,

il se passe de la magie.

Concrètement, ta vidéo normale,

tu peux la transformer en ultra slow motion.

Je ne rigole même pas, ça marche hyper, hyper bien.

Donc, c'est à dire l'équivalent de 240...

Et par exemple, tu passes de 25 fps à 240 fps.

Ça veut dire que maintenant, on pourra faire

enhance pour de vrai, je suis réellement...

Oui, je donne mes vraiment sur la vidéo.

Je parle des mouvements et des...

et des... et une résolution

qui sont décuplées comme ça.

Et ça demande juste de la puissance de calcul.

J'ai une question, justement, ça demande de la puissance de calcul.

Si je m'avance trop, tu peux répondre plus tard, tu peux.

À quel point ça pourrait arriver, par exemple, sur un iPhone ?

Parce que ce qui serait incroyable, c'est qu'un iPhone,

il puisse filmer en méga ralentis, que ça processe lui-même,

ça fasse le downscaling, ou quoi ?

Le upscaling, pardon.

Et qu'en fait, il a un ralentis, mais...

il y a... c'est pas l'alentis qui fait du 240 fps,

c'est le traitement qui te fait du 240 fps.

Et bien, du coup, le ralentis, ça s'appelle de l'interpolation.

Ok.

Donc c'est de l'interpolation par il y a.

Et pour répondre à ta question,

c'est extrêmement, mais extrêmement coûteux

Merde.

En performance.

Pour donner un ordre d'idée.

Une vidéo comme Unoscore,

pour la passée de 1080-30 à 4K 60,

ça prend 10 heures, à peu près.

Ah ouais, et ça coûte.

Et ça coûte.

Et donc,

Comment bien ?

Depends sur quelle machine tu l'as fait tourner.

Si tu l'as fait tourner sur ta machine,

ça peut coûter pas grand chose, tu vois, 10 heures à 700 watts.

Bon voilà, c'est peut-être 2 euros, j'en sais rien.

Ok.

Mais globalement, c'est très très raisonnable.

Par contre, si tu le mets dans le cloud,

ça commence à devenir très très cher.

Yes.

Vous l'avez compris,

en gros, c'est très très long,

parce que c'est 2-3 frames par seconde

de faire tout ce processing là.

Mais pourtant, ça marche bien.

Moi, j'ai essayé du coup en utilisant

la sortie d'une IA de génération de vidéo.

En la mettant dans topaz,

ça marche extrêmement bien.

Vous allez très bientôt voir le résultat.

Le problème, c'est que c'est long, c'est chiant.

Il faut 3 logiciels.

Globalement, je sais que les monteurs,

ils vont jamais l'utiliser.

En fait, c'est beaucoup trop lourd comme système.

Tu dois faire ta génération attendre 3 minutes.

Une fois que ta génération l'obscalaient,

attendre 3 minutes.

Enfin bref, c'est un enfer.

Ce qu'il faudrait, c'est un truc complètement automatisé.

Mais il l'a fait.

Il l'a fait à la fin.

Et c'est exactement ce que j'ai essayé de faire.

Donc si vous voyez à quoi ressemble l'algorithme

dans N8N, vous allez voir,

on va désoumé un peu.

Vous avez vu pour l'instant quelques petites briques.

En réalité, il est un petit peu plus compliqué

que ça.

Globalement, c'est un des workflow,

comme ils appellent ça,

les plus compliqués que j'ai jamais eu à faire.

OK.

Et ça n'utilise qu'une seule brique.

À un endroit, c'est celle de répliquite.

Tout le reste, en réalité, de ce que vous allez voir,

c'est de la gestion de Q, justement,

pour avoir un système de file d'attente

où les vidéos sont générées une par une.

Comme ça, en gros, le monteur, il peut...

Voilà, ça ressemble à ça.

Ouais, c'est pas juste les 3 étapes que t'as dit en fait.

Non, je me suis quand même bien amusé, effectivement.

Et globalement, tout ça,

c'est un système pour avoir une file d'attente

qui prend une par une chaque image en entrée,

qui va générer une vidéo,

qui va démarrer un serveur dans le cloud

avec un GPU,

qui va faire le upscaling automatiquement,

qui va le mettre en sortie

dans notre logiciel de traitement de rush,

qui s'appelle Fraymaio,

et qui va éteindre l'ordi.

Et en gros, tout ça est géré de manière intelligente,

où en fait, l'ordinateur s'allume uniquement

quand il a des générations à faire,

et hop, il s'éteint dès qu'il a fini,

avec des petites marges de sécurité.

On voit que t'as lancé tout tes runs à 18h22 ?

Voilà !

Exactement.

Le mec pas du toucher pour l'émission.

Mais justement, c'est ça qui est intéressant.

C'est que j'ai fait ça au dernier moment pour l'émission,

et vous allez voir ma vidéo finale,

combien de temps j'ai mis pour l'affaire.

T'as fait ça, pas faire le process,

tu l'as lancé à 18h21.

Il a lancé, ouais.

Je peux montrer à quoi ça servait, justement,

quel était l'utipité.

Je pense que ça avait 2-3 qui étaient en PLS.

Il a fait tout le schéma, là, 8h00 avant l'émission.

Oui, c'est ça.

Ok, c'est le moment d'avancer un peu dans la démonstration.

Concrètement, à quoi ressemble l'outip ?

Vous avez vu un truc nodal horrible,

les monteurs, eux, ils n'utilisent pas ça.

Ce qu'ils utilisent, c'est du coup un logiciel

qui s'appelle Frame.io.

Concrètement, c'est comme un Google Drive,

mais avec des vitesses de plots,

des donlots qui sont multiplis bar 20,

c'est beaucoup plus adapté à la vidéo.

Ça a été racheté par Adobe, d'ailleurs.

Exactement.

Chez nous, ça ressemble à ça.

Concrètement, on a un petit dossier qui s'appelle Video Gen.

Et dedans, n'importe qui dans l'équipe

peut Drag & Drop une image comme ça.

Donc là, prends une image dans l'été-chargement.

Je la mets dans le folder,

qui est une petite icône magique en haut.

Et c'est tout.

À partir de là, il est devenu,

je ne sais pas si vous avez vu, mais il est passé en Q'd.

Donc là, ça a été renommé.

Globalement, il vient de rentrer dans la file d'attente.

À partir de ce moment-là, il va être généré.

Ça va pouvoir prendre des minutes, mais moi, je me barre.

J'ai plus besoin de suivre le truc,

et je peux en mettre 50 comme ça.

Je n'ai pas à intervodir.

Ça, c'est quand même de la magie.

Et du coup, je me suis dit que j'allais vous faire une démonstration.

Quel point, c'est génial.

Pour ça, j'ai demandé à Chez GPT de m'inventer une histoire.

Ne me demandez pas pourquoi.

C'est une histoire qui parle de hacker et de roller.

De roller ?

Oui.

Ils se trouvent quand même au moment.

Je me suis mis au roller.

C'est vrai ?

Ok.

Et du coup, je vous ai imaginé une petite histoire de hacking sur roulette.

Je suis bien en roller au travail.

Pas encore.

Le niveau est pas suffisant.

Je lui ai demandé de m'imaginer une histoire,

un méchant, quelques scènes marquantes.

Il a imaginé des scènes dans la rue,

une confrontation entre le méchant et un hackathon.

Plein de scènes, parce que je n'avais pas trop d'idées.

Après, je lui ai demandé de générer 15 promptes pour Dali,

qui est le système intégré.

Et là, il y a un truc très précis.

Je lui demande un background et un foreground très distinct.

Je lui demande un premier plan et un arrière plan vraiment différent.

Pourquoi je demande ça ?

Parce que ces outils de génération, comme Stable Video Diffusion,

marchent vachement mieux si la scène est claire à comprendre.

Le pire qu'il puisse avoir à gérer,

c'est une scène très complexe.

En gros, tu n'arrives pas bien à lire le mouvement.

Il y a trop d'éléments.

Dès le prompt, j'essaye de l'orienter

pour qu'il me génère des images qui seront faciles à gérer.

Après, il m'a généré 15 promptes détaillées.

J'avais vraiment la flemme.

En plus, j'avais pas le temps avant l'émission.

Il m'a généré 15 images.

Ensuite, je lui ai demandé de les générer.

Une par une.

C'est une première image où le hacker est dans son labo.

Une deuxième image.

Très stylée.

C'est pas mal.

Celle-là, on peut l'afficher au bureau.

En hommage de cette chronique.

Tout ça, c'est des générations.

Générer une à chaque fois.

C'est pas une sélection.

Voilà.

C'est une toute très classe.

C'est le gang des méchants.

Dali s'est devenu stylée.

J'avoue, par habitude, j'utilise plus mi de journée.

Non, mais c'est devenu vraiment très bien.

Surtout, ils sont meilleurs maintenant en compréhension du print.

Le fait de créer la scène que tu veux.

Et voilà.

C'est la fin de...

Non, là, il est en train de démonter le truc du méchant.

Là, c'est le lab.

Celle-là, elle est belle.

Oui, elle est belle.

Je ne l'aimais pas trop.

Je la refais.

C'est le CEO qui annonce des mauvaises nouvelles.

À la fin de l'histoire.

En fait, c'est des index.

J'ai vérifié.

Ah ouais, mais alors...

Nous, on n'a pas vu ça tout de suite.

Mais 2-20...

Elle est pas mal clareux.

C'est moi, je n'avais pas remarqué, mais ça ressemble au logo de Lego, juste avant.

En fait, je ne l'ai pas demandé.

De la boîte ?

Oui, juste avant, le prompt, c'est...

Ça ressemble un peu, je trouve.

Non ?

Ça ressemble pas à ça, le logo de Lego ?

Ah, de Lego !

Le Lego les Joins.

Rougé les Joins, non ?

Je ne sais pas.

Ça ressemble à un truc, je trouve.

Ça me fait penser à un truc de bouffe, moi, mais...

Ouais.

Bref, donc ça, ce sont mes images pour commencer.

Vous avez bien vu que tout ça a été statique, évidemment.

Donc c'est un peu...

Voilà, moi, si je veux l'utiliser pour ma vidéo, où je suis en train de raconter l'histoire

d'un coeur célèbre qui avait des patins à roulettes,

eh ben, c'est un peu dommage, il n'y a pas grand-chose.

Donc, j'ai mis tout ça dans mon système.

En fait, moi, j'ai fait ça, comme tu l'as dit, j'ai fait ça à 18h20, à peu près.

Ouais.

Après, je suis parti.

À 18h45-50, toutes mes générations étaient faites.

Donc, en gros, ça a pris à peu près une demi-heure.

Ouais.

Donc, c'est pas rien, mais l'avantage, c'est que j'ai pas eu à être derrière à m'en occuper,

tu vois.

Je suis revenu 30 minutes plus tard, j'ai téléchargé tous mes rushs, je les ai mis à la suite,

et voilà, en gros, ce que ça donne.

Et donc, c'est ça qui est exporté, et que le fait qu'on a eu...

Et 3 minutes de retard.

Exactement.

Je n'ai même pas regardé le résultat.

Ah, t'es en train de découvrir avec nous, là ?

Oui.

Oh...

T'as regardé pas mal, ça, là.

Elle est vraiment très cool, là.

Et...

Je me mettrave le montage.

Oh, mais je suis choquée !

En fait, j'avais pas vu.

En vrai, stylé.

Pour l'instant, c'est sans faute, hein.

Ouais.

Ouf.

Non, mais c'est pas mal, hein.

Ça fait un... on dirait un...

Non, c'est un peu bizarre.

Mais on dirait que c'est un accéléré.

Ça, c'est très cool.

Ce plan, là.

Mais je suis choquée, par contre.

Non, mais tu sais que tu prends chaque plan.

Regarde, les mains, tu sais, du gars, on dirait que c'est un...

Ça, on ne fait personne du tout.

Quoi ?

Celle-là, elle est magnifique, aussi.

Ouais.

Oh, celle-là.

Celle-là, elle est cohérente, ça.

Ouais, elle est cohérente de fou.

Ah, on nous met une musique, en plus ?

Très stylée.

Oh !

Trop mal, oui.

Le mec, il a disparu.

Je sais pas pourquoi.

Ouais, mais...

En fait, ça, ça le fait.

Ça le fait.

Il y a un petit problème sur les visages, mais à voir ça.

Ouais.

Et là, je crois que c'est là.

Il en reste une, à la fin.

Ouais, ça va.

En double, peut-être.

Oui, je pense que j'en ai fait plusieurs générations, en fait.

Voilà, après, je l'ai remis.

Mais alors, tu sais que si tu rajoutes une bonne musique de trailer

et que tu raccourcis un peu les roches, là, c'est un peu long.

Ouais, ouais, ouais.

Déjà, là, ça...

Comme le trailer de Star Wars.

Ouais, ouais.

Tiens ça, elle est très vite.

Je pense que si tu vas...

Si tu cutes un peu les plans plus vite...

Je sais refait !

En fait, c'est trop bien, parce que...

Oh, là, c'est très cool, ouais.

Je n'ai pas eu le temps de voir les résultats.

En fait, ce qui me choque le plus, c'est le tour des réussites.

C'est-à-dire que dans les essais que je faisais,

j'ai mis beaucoup de temps, en fait, à trouver les piles des bons paramètres à ajuster.

Parce que, là, comme vous l'avez vu, c'est hyperfluide,

c'est des longs plans, ça dure 5 secondes.

Alors, ce qui sort de mon modèle d'IA, c'est uniquement 25 frames.

Je ne sais pas si vous réalisez.

Oui.

Donc, l'IA génère 25 frames.

C'est pas beaucoup, tu vois, c'est juste 25 images.

Et du coup, j'ai mis beaucoup de temps à trouver, ok,

est-ce qu'il vaut mieux générer 5 secondes à 6 fps,

ou 1 seconde à 25, et après, le slow motion vaut mieux faire 2 fois, 3 fois, 4 fois.

Bref, j'ai pris beaucoup de temps à fine tune-er tout ça.

Et je suis trop content, parce que vraiment, le résultat, là,

c'est genre 4 ou 20 % de réussite.

Mais du coup, combien de temps ça t'a pris pour fine tune-er tout ça, à peu près, là ?

Bah, quelques jours.

Oui, j'ai pris pas mal de générations, j'ai testé pas mal de trucs.

Et globalement, quelques jours.

Par contre, là, sur la partie prompt,

qui peut être améliorée aussi pour avoir un style un peu consistant, etc.,

qui soit un peu toujours le même,

j'ai passé 5 minutes,

enfin, vraiment, c'est la seule conversation que vous avez vu avec ChargeGPT.

C'est vraiment très cool.

Je vois que dans le chat, certains se font...

IP.

Donc, je suis très content.

Je vous l'ai dit, c'était...

Voilà, c'était une expérience comme ça, en 10 jours.

Mais je suis sûr qu'on peut aller encore plus loin.

Notamment, j'ai des idées où là, on passerait vraiment à niveau de mindfuck mais supplémentaire.

Parce que là, toute l'interaction que j'ai eu avec ChargeGPT pour générer l'histoire, les prompts, etc.,

quand on y pense, ça s'automatise en vrai.

Genre, j'ai rien fait d'incroyable.

J'ai lui demandé de générer des prompts à l'appel,

quelques questions un peu ciblées.

Mais, en fait, ça, maintenant, c'est une brique.

J'ai une brique qui me fait image tout vidéo de 5 secondes qualitatives

avec haute fréquence.

C'est une brique.

Maintenant, on peut la coller avec d'autres trucs.

Par exemple, imaginons.

Un système qui lirait une vidéo que je viens de tourner.

Je suis sûr.

Qui lit le script en entier.

Après qui la découpe en chapitre logique.

Après qui prend chaque chapitre et qui imagine, je ne sais pas moi, des scènes,

qui illustrerait de différentes manières la plus sympa possible et visuelle

ce qui est raconté dans la vidéo.

Et hop, après, la brique qui automatiquement va transformer

ces générations d'images en génération de vidéo.

Ça va prendre probablement 24 heures sur toute une vidéo

parce que c'est très très long.

Mais c'est pas grave, le truc est fait pour marcher tout seul.

Et du coup, il reste du montage.

Enfin, encore une fois, c'est pas parfait du tout.

Il y a une génération sur deux qui en général n'est pas terrible.

Mais globalement, ce que ça fait, c'est que tu commences ton montage.

T'as déjà genre 50 assets, 50 vidéos ultra contextuelles

pile dans le style qui te va à toi.

Donc peut-être tu veux du noir et blanc,

peut-être tu veux du format dessin animé ou ultra réaliste

avec tes couleurs à toi, de ta boîte.

Et tu peux avoir 50 vidéos comme ça, qualitatives,

pile en lien avec ta vidéo qui te sont générées

avant même que tu es commencé à monter.

T'as pas encore travaillé, t'as rien fait.

Bon ça t'a coûté quelques euros en génération.

Justement, ça coûte combien, genre,

là, ce que tu as fait par exemple, tu as combien cette course sur répliqueite ?

Une vidéo, ça coûte à peu près 10 centimes, à mon avis.

Ah, ça le mo?

Bah, c'est pas beaucoup en vrai.

Genre 10 centimes, c'est pas beaucoup.

Là je parle d'une vidéo de 5 secondes.

Donc tu as un plan.

Ah oui, oui d'accord, c'est en réalité.

Pardon.

Donc là, il y en avait 10, là il y a une quinzaine.

Donc là, en gros, j'ai à peu près payé un euro 50.

Franchement, il y a moyen que ça baisse encore, etc.

Mais bon, je l'ai payé toujours.

Je l'ai payé toujours en fait quand tu es...

Quand tu imagines ce que j'aurais été capable de faire sinon dans les 10 minutes que j'ai passées à faire ça,

sans ce système là,

franchement, tous les jours je l'ai payé.

Oui, ça vaut carrément le coup, c'est clair.

Et en fait, il faut comprendre que par exemple, si on prend une vidéo underscore,

il y a des enjeux d'illustrer des vidéos sur des sujets où parfois ça dépend des sujets.

Mais il y a des sujets où c'est très dur d'illustrer quand on commence à parler de développement

ou de choses comme ça, ou même de cyber, en fait, ça dépend des sujets.

Et il y a vraiment un enjeu du côté de nos monteurs de...

Par exemple, quand je parle actuellement,

qu'est-ce qu'on peut afficher pour garder l'attention pour que ça soit sympa,

soit que ça soit joli, soit que ça soit informatif, soit que ça apporte quelque chose.

Et donc, il n'y a pas que des illustrations styles que tu as fait,

parfois c'est des schémas, etc.

Mais il y a aussi des plans un peu plus posés.

C'est clair.

Si on parle d'une ville, ça affiche la ville.

Si on parle d'un truc...

Ça peut être plein de trucs.

Et ça peut être répandu parce que tu viens de dire...

C'est un vrai usage.

Parce que peut-être les gens, ils ne s'en rendent pas trop compte.

Là, pour mon film de vacances, ça ne va pas m'aider.

Mais pour nous, par exemple,

regardez les vidéos underscores, vous verrez, ça a des usages.

Ça peut faire un peu de gadget,

parce que la plupart du temps, on s'imagine que c'est pour illustrer un compte pour enfants.

Mais non, pour plein d'autres usages,

avoir des images contextuelles

qui vont compléter toujours des illustrations manuellement,

parce qu'il y en a besoin.

En fait, c'est hyper cool.

Du coup, maintenant, dès qu'on va avoir des illustrations,

mais pas forcément sur les vidéos que d'underscore,

mais n'importe quoi sur YouTube,

ça va très potentiellement être généré...

Il y a des chances que dans le futur, ça arrive petit à petit.

Ce qui est sûr, c'est que dans les...

Voilà, ça a déjà un peu...

En tout cas, nous, on va l'essayer sur les prochaines vidéos VOD.

D'underscore, vous nous direz ce que vous en pensez, tout simplement.

Quelqu'un qui dit cette conversation dans 1 à 5, on a un petit pont.

C'est clair, exactement.

Mais là, moi, c'est avec des bouts de ficelles,

je dois tout constamment trouver des hacks

pour contourner les limitations,

le nombre de frames, etc.

Franchement, dans 1 à 5 ans, j'imagine même pas.

Et oui, comme dit très justement le chat,

ça peut permettre d'illustrer des vidéos

comme des vidéos stock.

Oui, complètement.

Ça vient complètement pour moi.

C'est beaucoup moins cher que vidéo stock.

Exactement.

Non mais...

D'ailleurs, ça coûte combien, les vidéos stock ?

Cheikh.

Ça peut coûter des dizaines d'euros pour un plan.

Ça va tuer leur business.

Mais exactement.

Ça va tuer le business de...

Je crois que...

En voyant rien, c'est très cher.

Je viens de tuer le business de Adobstock.

Ou de Shutterstock.

Ou de Shutterstock, etc.

Non mais c'est littéralement calme.

Et t'as beaucoup moins de contrôle sur le style, la qualité,

des petits détails.

Là, tu peux dire, ok, mais mon plan en drone de New York,

en fait, là, je voudrais 2 drones,

parce que à ce moment-là, dans l'histoire, j'en ai besoin.

Tu peux pas le faire avec les vidéos stock.

Pour l'instant, ils ont encore l'avantage sur les humains,

parce qu'on l'a vu, c'est quand même plus difficile de faire le main.

Mais ça va pas dire.

C'est clair.

Ça va, ça va aller très vite.

Moi, j'ai une petite question à la con, mais sur N8N,

ça ressemblait vachement à Node-RED, l'interface.

Tu sais, s'il y a un lien ou non ?

Non, il n'y a pas de lien.

Il y a des d'espiration, parce qu'il y a tout ce qu'ils font,

les uns et les autres.

Ce n'est pas un marché gigantesque, le Nodal, la programmation Nodal.

Il y a un petit lien, mais il y a quand même des grosses différences.

Notamment, je ne sais pas comment dire ça,

mais en gros, Node-RED, si je ne dis pas de conneries,

c'était Phil, il représente des Input et des Output.

Donc tu peux vraiment avoir ton neu, il va y avoir plusieurs entrées

qui correspondent à des différents paramètres que tu dois renseigner,

un peu comme sur Unreal.

Alors que N8N, ce n'est pas ça.

Il y a toujours une entrée.

Par contre, tu te transmets des petits bouts d'objets,

des gizons qui ont des enfants.

Donc, c'est un peu pareil.

C'est de l'inspiration.

Voilà, c'est un peu inspiré.

Voilà.

Cool là.

Est-ce que vous êtes ça cool ?

Et pour la petite anecdote,

dans la chronique qui va arriver,

on avait une interview,

donc il fallait l'exporter, mâcher un truc de mon teur.

Il l'a de lui-même mis sur frame dans Upscale 4K.

Et du coup, si j'ai bien compris,

il est passé de 720p,

parce que c'était une série en 720p,

à 4K.

Je ne le fais pas si tu veux.

Du coup, là, tu as vu que vous allez voir tout à l'heure,

elle a été upscalée.

C'est qu'il n'y a aucune friction,

sinon, on ne le fait jamais.

Donc là, on n'a même plus à se poser la question.

Sur ce, pour le comment chaine.

Sur un fond, merci pour cette chronique.

J'étais déjà étonné d'avoir des plutôt beaux résultats

dans l'heure qui arrive.

Mais là, j'ai doublement agréablement surpris.

On va pouvoir titrer cette vidéo.

On génère des images d'illustration en 1h.

C'est le truc en 1h ou en 60 minutes.

J'ai un ou ?

Ou alors ?

J'ai vu ses yeux briller.

Il est parti.

On met Adopstock au chômage.

Bon, on va y aller.

On a pensé quoi, le challenge ?

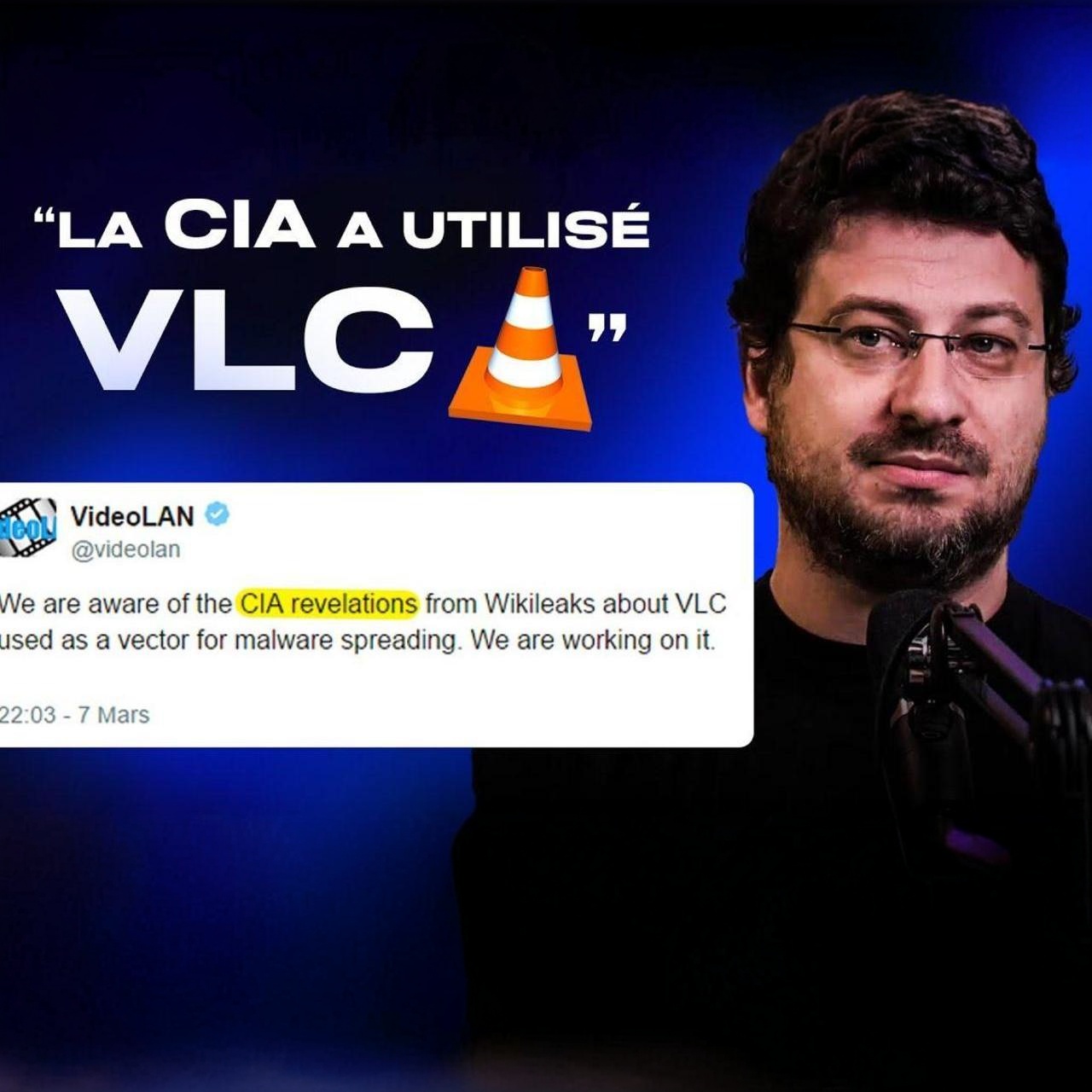

Le jour où la CIA a tenté d’influencer VLC — Jean-Baptiste Kempf

Le jour où la CIA a tenté d’influencer VLC — Jean-Baptiste Kempf