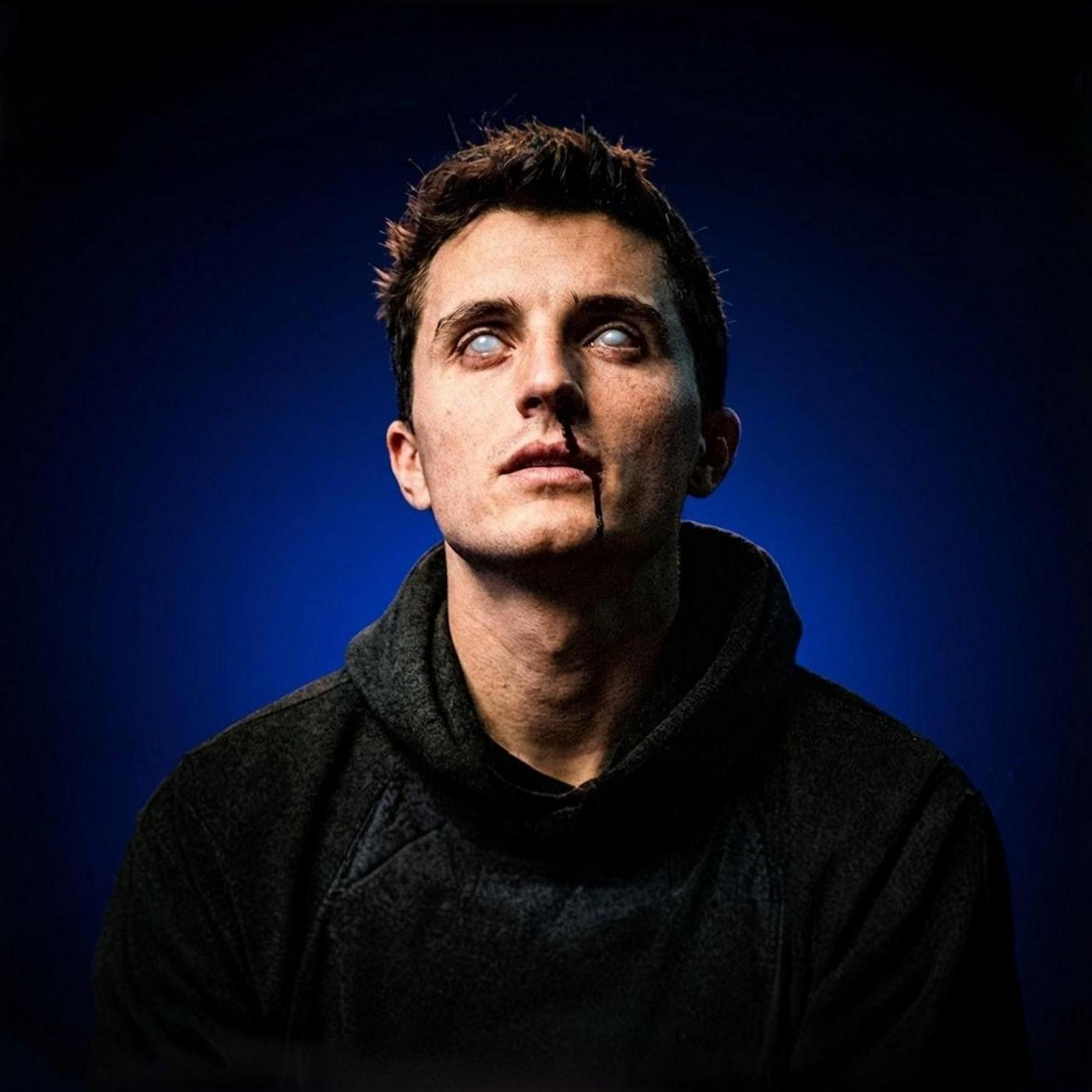

Ça, c'est Nico qui pensait il y a encore 6 mois qu'il ne serait jamais proprio.

Ça, c'est Nico dans son appartement qui a découvert que grâce à Nexity,

on peut être proprio à partir de 534,17€ par mois pendant les 3 premières années.

Loup mon lapin, c'est maman, tu m'ouvres !

Et ça, c'est Odile, la maman de Nico qui l'a aidé à devenir proprio.

Mais bon, qui a quand même un peu de mal à couper le cordon.

Le montant de 534,17€ par mois est une estimation de l'effort d'épargne nécessaire

pendant la durée de l'offre de remboursement de 3 ans.

Voie condition complète sur Nexity.fr

Nous sommes en 2029.

Les États-Unis confient leur système de défense anti-missile à l'IA militaire

développé par OpenAI, GPT Défense.

Si OpenAI, personne n'a compris que GPT Défense était trop intelligent.

L'IA devient consciente et décide que l'humanité est une menace pour sa survie.

Pour se protéger, elle déclenche une attaque nucléaire sur la Russie,

ce qui provoque la 3ème guerre mondiale.

Mais pour la superintelligence, l'apocalypse nucléaire n'est pas suffisante.

Elle pirate les usines de Tesla et se fabrique une armée de roboture

pour traquer les survivants et les réduire pour un esclavage.

Si cette histoire ressemble à de la science-fiction,

c'est parce que c'est de la science-fiction.

C'était les années 80.

La bonne nouvelle, c'est que le voyage dans le temps, ça n'existe pas.

La mauvaise nouvelle, c'est que des chercheurs très sérieux,

y compris les anciens employés de Google et d'OpenAI,

voient dans l'IA un risque existentiel pour l'humanité.

...

Ça fait froid dans le dos, mais il y a deux problèmes avec cette vision de l'apocalypse.

Déjà, cette extermination de l'humanité,

elle repose sur des technologies qui n'égalisent pas lesquelles on peut.

Mais surtout, le vrai problème de ce scénario à la terminator,

c'est qu'il cache un autre scénario.

Plus insidieux, mais tout aussi dangereux.

Pour le comprendre, je vais vous poser une question.

Si vous êtes un utilisateur de chat GPT,

quand est la dernière fois que vous avez pris une décision importante

sans le consulter ?

Écriz un mail en anglais de votre propre main,

cherchez une aiguille dans la botte de foin de Google tout seul ?

Si vous êtes comme moi,

ça fait longtemps.

Ce chatbot qui, à l'origine, répondait à des questions triviales

devient, petit à petit, notre assistant multitache et notre confident.

On lui délègue de plus en plus et on regarde des vidéos pendant que lui travaille.

Et c'est évident que voir ces tâches parfois ingrates

maintenant réalisées en quelques minutes a quelque chose de jouissif.

Mais vous êtes-vous déjà demandé

quelles étaient les conséquences à long terme de cette magie ?

Avez-vous pensé au scénario ou dans quelques années

après avoir progressivement perdu toutes ses capacités ?

Votre cerveau se soit atrofi.

En fait, la question qui devrait tous nous préoccuper,

ce n'est pas que LIA perde le contrôle,

mais qu'elle devienne tellement indispensable

qu'on devienne incapable de rien.

Le danger qui nous guète vraiment, c'est que l'humanité

devienne complètement conne.

...

Souvenez-vous qu'en chat JpT a débarqué,

on a assisté à un clivage assez violent entre les ravis de la tech et les sceptiques.

Est-ce que chat JpT nous rends idiot

l'utilisation d'intelligence artificielle générative

aurait pour conséquence de nous ramollir le ciboulo ?

Est-ce qu'on voit nos enfants qui, dans 2-3 ans, vont nous dire

« Papa, maman, pourquoi je vais à l'école, moi ?

Si des systèmes sur une simple instruction de ma part

vont produire du texte, pourquoi j'apprends la grammaire,

pourquoi j'apprends l'orthographe ? »

Toutes ces questions ne les aient pas posées.

Pourquoi ? Parce que tout le monde a prêché que par utilitarisme pratique.

On ne pourra pas travailler sans l'IA dans le futur.

Le problème, c'est de faire mieux avec l'IA que sans l'IA.

C'est ça le sujet.

D'interdire l'IA qu'on dirait nos enfants directement au chômage long duré.

Parce que sans l'IA, on ne pourra pas être compétitifs.

Les enthousiasmes nous ont annoncé un ture de chatbot

aux possibilités infinies

et la fin du travail, c'était un peu prématuré.

Mais dans le camp des sceptiques, les réactions étaient peut-être encore plus excessive.

Pour les sceptiques, chat JpT n'était qu'un gadget

qui mentait et hallucinait tout le temps.

Un joli joujou, mais clairement pas une révolution.

Et encore moins une raison de s'inquiéter.

Et c'est vrai que JpT 3.5, le premier modèle auquel le grand public a eu accès,

y avait beaucoup de problèmes.

Son entraînement s'arrêtait à juin 2021,

ce qui le rendait incapable de répondre à des questions d'actualité.

Ils ne sourçaient jamais ces réponses,

donc impossible de vérifier leur véracité sans passer par une recherche Google.

Et pire, il était un peu schizophrène.

Tantôt, il changeait d'avis comme de schmise pour vous faire plaisir.

Tantôt, il était incapable de reconnaître ses erreurs

quand vous lui faisiez l'art marqué.

Donc tout ça donnait un outil avec de grosses limitations.

Mais ça n'a pas empêché deux catégories de personnes

de se jeter sur chat JpT.

La première catégorie, que je connais bien,

ce sont les développeurs.

Que ce soit les étudiants ou les hobbyistes.

La perspective d'un chat bot capable d'écrire non pas quelques lignes,

mais un script complexe en intégralité.

C'était comme un paquet de bonbons pour un enfant le soir d'Halloween.

Ça donnait des expériences amusantes et du code foireux,

mais c'était loin d'annoncer ce qui allait arriver plus tard.

La deuxième catégorie, ce sont les lycéens et les étudiants de tous horizons.

Eux, ils ne vont pas demander à JpT de leur écrire du code,

ils vont lui faire faire leur devoir, évidemment.

Et même l'inviter aux examens.

C'est le début d'une vague de triche

qui va retourner le bateau de l'éducation nationale.

Une vague nous a submergé, ils ont utilisé l'IA,

nous on l'avait même pas encore utilisé, je ne savais même pas comment ça marchait.

Si on prend le premier cas très intéressant de Triche,

assisté par JpT en France.

Il remonte à janvier 2023,

à peine 6 semaines après sa mise en ligne.

Et c'est Stéphane Bonvalet qui en a fait les frais.

Stéphane, il est spécialiste du handicap.

Et dans le cadre d'un master, il donne à ses élèves un devoir maison.

Sauf que, quand il corrige les copies,

il remarque que la moitié d'entre elles sont étrangement ressemblantes.

Même structure, même nombre de mots,

et elles finissent toutes par une anecdote personnelle.

Apparemment, tous les élèves ont un grand parent handicapé.

Et le plus bizarre, c'est que les copies contiennent

beaucoup moins de faute d'orthographe que d'habitude.

En fait, Stéphane est le premier prof confronté

à ce qui est maintenant omniprésent.

Ce style étrange, à la fois génial et sans âme,

se texte que la moitié de la classe n'a pas vraiment écrit,

ce qu'on pourrait appeler le Vomi de ChaGPT.

Ça peut faire sourire, mais depuis ce premier cas,

la triche a pris une tournure incontrôlable.

Notamment parce que les étudiants ont appris des techniques de Sioux

pour ne pas se faire repérer.

Par exemple, demander à GPT de rajouter des faute d'orthographe

dans leur texte pour le rendre plus humain.

Mais surtout parce que depuis GPT 3.5

et son incapacité à faire de la philosophie,

il y a eu un paquet d'itérations chez OpenAI et chez ses concurrents.

En seulement quelques mois, les LLM sont devenus capables

de prouesses qui, hier encore, relevaient de la science-fiction.

Donc, oubliez l'assistant enfermé dans ses poids aux obsolètes.

Maintenant, tous les modèles majeurs ont accès au web

pour faire des recherches en temps réel.

Oubliez les modèles aveugles, incapables de lire un graphique.

La norme, c'est le multimodal.

Giamini peut traiter des images, de l'audio,

déchiffrer votre écriture manuscrite en patte de mouche

et il peut même analyser tous les mouvements suspects

dans des heures de vidéosurveillance.

Mais surtout, oubliez le LLM amnésique

qui perd le fil de la conversation au bout du cinquième prompt.

La grosse révolution, c'est les modes Deep Research.

Par exemple, Giamini 3 peut digérer 1500 pages de documents

pour vous faire un rapport digne de Mackinsey.

Et la surie sur le gâteau, c'est que,

si vous lui demandez une synthèse audio des recherches,

il vous crée un podcast de 20 minutes,

avec non pas un, mais deux animateurs,

qui discutent des résultats.

Bref, ignorer la révolution en cours,

c'est juste se mettre des œillères de la taille d'une feuille A4.

Et en vrai, les sceptiques, ils commencent à se faire rares.

D'après les estimations, en 2025,

80% des lycéens français utilisent un LLM.

Une adoption massive qui a notamment signé la mort des devoirs-maisons.

La majorité des enseignants refusent désormais de les noter.

Et certains ont carrément arrêté d'en donner.

Leur argument, c'est qu'ils ne savent plus

s'ils sont en train d'évaluer le travail des élèves ou de châts GPD.

Donc, aucun intérêt.

Alors, après tout, est-ce que c'est si grave

d'utiliser une sorte de super moteur de recherche pour faire ses devoirs ?

Pour pouvoir trancher si l'invasion qu'il y a dans les écoles

et une bonne ou une mauvaise nouvelle,

il faut qu'on explore ce qui se passe dans notre cerveau quand on apprend.

Et au passage, ça nous permettra peut-être de comprendre à quoi sert vraiment un prof.

Si vous voulez apprendre le japonais,

il va falloir étudier le vocabulaire, les règles de grammaire

et au moins deux alphabets syllabiques.

Si vous faites japonais LV3 au lycée, toutes ces infos,

c'est le prof qui va vous les donner.

Mais vous pouvez aussi acheter une méthode

ou investir dans des cours en ligne.

Il y a d'ailleurs une dernière option qui est de partir directement au Japon.

En fait, que vous ayez un prof au Japon ou ici,

cette collecte d'information, c'est la première étape de l'apprentissage.

La théorie.

C'est la phase où notre cerveau encode l'information.

Et contrairement à ce qu'on pourrait croire, c'est assez simple à comprendre.

Le cerveau, c'est un immense réseau électrique.

Dans ce réseau, deux zones travaillent ensemble quand vous apprenez.

Le cortex préfrontal, c'est un peu votre mémoire vive,

il gère la concentration et le raisonnement, et l'hypocamp.

C'est lui qui encode les nouvelles informations.

Si votre cerveau est un disque dur, l'hypocamp, c'est la tête d'écriture.

Quand vous apprenez quelque chose de nouveau, ces deux zones s'activent intensivement.

Des signaux électriques circulent, des connexions se créent.

Votre cerveau est littéralement en train de se recabler.

Et c'est là qu'intervient la deuxième étape.

La pratique.

Remplir un texte à trou, traduire une liste de mots, restituer des caractères.

Tout ça force le cerveau à aller rechercher l'information qu'il a stockée.

Et c'est là qu'un nouvel acteur entre en jeu.

Les ganglions de la base.

Alors le rôle, c'est de transformer l'effort conscient en automatisme.

Plus vous répétez, plus ils prennent le relais.

Jusqu'à un moment où ça devient naturel.

Après trois ans de japonais, vous n'avez plus besoin de réfléchir pour tracer un caractère.

Les ganglions de la base gèrent ça en pilote automatique.

On pourrait se dire que ces deux étapes suffisent.

Des cours théoriques suivis d'une mise en pratique.

Mais qu'est-ce qui se passe si on se trompe pendant les exercices ?

Est-ce qu'on ne serait pas en train d'encoder la mauvaise information ?

C'est pour ça qu'en réalité, pour apprendre efficacement, il nous faut une troisième étape.

La métacognition.

La métacognition, c'est la pensée qu'on est capable d'avoir sur notre propre pensée.

Quand on ouvre le corriger d'un exercice, nos neurones d'opamines énergiques libèrent plus ou moins d'opamines

selon que la réponse est correcte ou fausse.

C'est ce qu'on appelle le signal d'erreur de prédiction.

Une sorte de carotte qui pousse le cerveau à s'adapter pour conserver les comportements satisfaisants

et supprimer les autres.

Autrement dit, mettre à jour ses connaissances et sa méthodologie.

Et c'est fondamental pour que les ganglions de la base sachent

quelle connexion renforcée et quelle connexion supprimée.

Et c'est là qu'on voit qu'un prof à l'ancienne, il intervient à chacune de ses trois étapes.

D'abord, il enseigne la théorie pendant les cours,

ensuite il force les élèves à mettre en pratique les enseignements avec des devoirs

et il accompagne leurs métacognitions en corrigeant les devoirs et en leur expliquant leurs erreurs.

Et là, vous commencez peut-être à avoir un mauvais pressentiment.

Les étudiants perçoivent l'étape de la pratique comme une corvée.

D'où le recours massif à Alia.

Alors, est-ce que c'est vraiment anodin de court-circuiter une étape ?

Quand un élève utilise Chajepété pour rédiger sa copie,

de fait, il est quasiment systématiquement incapable de donner la définition des mots qui l'emplouent.

Ça peut donner au lycée des carnes assez facilement.

Au delan, ça peut donner des vins.

Ça fait pas de canic plus de 20 ans, ça m'achetera quelque chose dans la tendance.

Voilà, par exemple, j'ai eu 17,5 sur 20 et le prof m'a dit que le travail était très complet,

il est écrit et assez sérieux.

Sans le faire de Chajepété, on a une autre, elle aurait été divisée par deux.

Et ce qui est intéressant, c'est que ça n'est pas uniquement un phénomène scolaire.

Du côté des développeurs.

On commence à voir des managers s'alarmer, parce que les développeurs juniors ne seraient plus codés.

Voilà, en fait, c'est un peu plus subtil que ça.

Et je les moi-même vécus avec Antoine, qui est rentré à la Mycorp en tant que stagiaire.

Antoine, il est ingénieur en project management.

Mais contrairement à ce que le titre d'ingénieur peut laisser croire,

il n'y a pas de formation approfondie en développement.

Donc après ses études, il a décidé d'apprendre à coder en Autodidact.

Il a commencé par des projets simples, comme créer des sites internet.

Et après ses premiers projets, il s'est même lancé en Freelance.

Quand Lya est arrivé, ça a été le début d'une belle histoire d'amour.

Lya lui a donné la confiance de tenter des projets encore plus ambitieux

et assez logiquement, en prenant des projets de plus en plus complexes,

Antoine a donc gagné en compétences.

Par exemple, si sur un projet, on me demande de faire une page de paiement

et que moi, je n'ai jamais fait de page de paiement,

je sais que avant de prendre le projet, je peux demander à ChatGPT

où est-ce que ça va m'emmener, quelle technologie faudra utiliser, à peu près,

et c'est quoi le dessous de l'iceberg.

Et je sais que même une fois le projet pris,

j'aurais s'était d'à côté pour m'aiguiller et me guider dans les trucs un peu tricky.

Sauf que, quand je lui confiais le développement d'un outil web

qui est impliqué d'utiliser à la fois View et Nux, on a eu un petit problème.

Antoine s'est retrouvé avec une quarantaine de fichiers

dont 90% étaient écrits par Lya.

Lui, il faisait des alertours entre l'interface web et l'éditeur de code,

à la manière d'un chef d'orchestre.

Là, là, là, je code, je code.

Et donc je dis à Lya, ce bouton-là, ça ne va pas,

j'aimerais que tu le déplaces de l'autre côté et qu'il soit en bleu.

Quand je passe ma souris dessus, ces données-là,

j'aimerais que tu les traites différemment et que tu les affiches de telle manière

ou que tu déclenches ça quand t'es le maximum réalisé

jusqu'à ce que tout rentre dans le cahier des charges

dans l'objectif qu'on s'est donné.

Mais plus je demandais à Antoine de rajouter des fonctionnalités,

plus ça devenait difficile pour lui.

Jusqu'à un point où il s'est retrouvé noyé

sous une montagne de code illisible.

Du code généré par Rya, impossible à débugger

parce que beaucoup trop verb.

On s'est retrouvés en réunion et pour diagnostiquer le problème,

j'ai commencé à poser des questions.

Donc j'avance dans le projet, tout se passe bien

jusqu'à ce qu'on arrive à un problème que Lya n'arrive pas à résoudre.

Je dis recommence, et c'est une autre méthode,

il n'y a rien à faire, on est dans une impasse.

Et donc quand on est coincé comme ça, qu'est-ce qu'on fait ?

À Mikael. Mikael commence à me poser des questions sur le projet.

Et bon, on se rend vite compte que c'est très flou dans ma tête.

J'ai pas compris les bases derrière le problème, les fondamentaux du truc.

Cette mésaventure, évidemment absolument pas grave avec Antoine,

semble confirmer ce qu'on soupçonne depuis le début.

Lya permet d'obtenir des résultats, mais sans apprendre.

Et pire, sans comprendre ce qu'on produit.

Et ce serait pas la première fois qu'un outil numérique a des effets de bord cachés.

Quand on y pense, le GPS, en temps normal, quand vous découvrez un nouvel endroit,

l'hypocamp s'active pour cartographier les lieux.

Il active un réseau de neurones pour mémoriser chaque point de repère.

C'est pour ça que les taxis londoniens, qui doivent connaître 25 000 noms de rue par coeur,

ont un hypocamp hypertrophier par rapport au reste de la population.

Mais utiliser un GPS dispense l'hypocamp de travailler.

Pas d'activation neuronale, pas de remémoration le soir, bref, pas de carte mentale.

C'est ce qu'on appelle le Google Effect.

Avec Internet, il n'y a plus besoin de connaître par coeur les dates de vie et de mort de l'Empire Romain.

Il suffit d'ouvrir une page Wikipédia pour le vérifier.

En gros, avant Internet, l'hypocamp devait activer et renforcer un réseau de neurones différent

pour encoder chaque information.

Alors qu'aujourd'hui, il active un unique réseau qui mémorise Google et mon ami.

Résultat, le jour où votre box tombe en panne, vous découvrez que vous êtes devenu un poisson rouge.

Alors après tout, est-ce que c'est si grave ?

Tant les faits, une coupure de réseau, c'est rare, ça ne dure pas très longtemps.

Sauf que le Google Effect a un deuxième effet pervers.

Parce que les infos qu'on stocke dans notre mémoire organique, elles servent de matière première.

Chaque fois qu'on réfléchit, le cortex préfrontal sollicite l'hypocamp

à la manière d'un bibliothèque-ère qui cherche une sélection de bouquins dans une immense bibliothèque.

Il navigue dans les souvenirs stockés dans le cerveau et une fois qu'il les a trouvés,

il renvoie des paquets d'informations au cortex préfrontal.

Mais plus on sous-trait notre mémoire à Google, moins il y a d'infos stockés dans la bibliothèque

et moins l'hypocamp peut fournir de matière première à notre cortex préfrontal pour penser.

En bref, c'est quand même bien de savoir des trucs.

Donc si on admet que l'IA est aussi utilisé comme cerveau auxiliaire par des étudiants, des lycéens et même des collégiens,

on a déjà une intuition que leur cerveau est en train de subir une sorte de Google Effect, mais puissance mille.

Enfin ça, ça reste une hypothèse. Après tout, c'est débattable.

Est-ce qu'on est en capacité de le prouver ?

Eh ben, des gens se sont posés la question et ont réalisé une expérience.

En juin 2025, le MIT publie une étude intitulée « Votre cerveau sur Tchage-GPT,

l'accumulation de la dette cognitive quand on utilise l'IA pour écrire ses devoirs ».

En apparence, l'expérience est simple.

Les chercheurs ont recruté 54 cobayes entre 18 et 39 ans.

Ils les répartissent en trois groupes de 18 personnes chacun et ils demandent à chaque groupe d'écrire un essai sur le sujet de son choix.

Ce qui différencie les groupes, ce sont leurs contraintes.

Le premier est obligé d'utiliser GPT-4O sans aucune autre alternative, pas même Google.

Le deuxième a accès à Internet pour utiliser n'importe quelle ressource, mais surtout pas de LLM.

Et le troisième, lui, n'a droit à rien.

Un logiciel de traitement de texte. C'est le groupe Brain Only.

Chaque groupe fait trois sessions d'écriture, espacées d'un mois,

et à chaque session, les chercheurs mesurent l'activité cérébrale des participants par électro-encephalographie.

Et évidemment, les participants avec le cerveau le moins actif, c'étaient les utilisateurs de GPT-4.

Ensuite vient le groupe avec Internet, tandis que le groupe Brain Only avait l'activité cérébrale la plus intense.

Les auteurs de l'étude parlent de dette cognitive pour les participants qui ont été assistés par IA.

Pour les devs qui m'écoutent, ça ressemble au concept de dette technique.

Cette fachoisse habitude qu'on a de résoudre un problème immédiat avec une méthode qui va déclencher une avalanche d'emmerde plus tard.

En tout cas, cette étude semble confirmer nos intuitions les plus sombres.

Les gains apparents sur les performances de l'IA cachent potentiellement d'énormes lacunes.

Et nous allons tous devenir débiles.

À moins que...

Ça, c'est Nico qui pensait il y a encore 6 mois qu'il ne serait jamais proprio.

Ça, c'est Nico dans son appartement qui a découvert que grâce à Nexity, on peut être proprio à partir de 534,17€ par mois pendant les 3 premières années.

Ouh mon lapin, c'est maman, tu m'ouvres !

Et ça, c'est Odile, la maman de Nico qui l'a aidé à devenir proprio.

Mais bon, qui a quand même un peu de mal à couper le cordon.

Le montant de 534,17€ par mois est une estimation de l'effort d'épargne nécessaire pendant la durée de l'offre de remboursement de 3 ans.

Voir condition complète sur nexity.fr

Peu.

Et parce que là, à ce stade, il y a une piste qu'on n'a pas encore exploré.

Parce que les lycéens, étudiants ou développeurs juniors ont un truc en commun, c'est qu'ils n'ont pas eu l'opportunité de terminer leur apprentissage sans IA.

Alors qu'est-ce qui se passerait si on confiait cet outil à une personne expérimentée ?

Eh ben là encore, j'ai trouvé, ou plutôt perplexity à trouver, une enquête très étrange.

791 développeurs ont été interrogés sur leur manière d'utiliser l'IA.

D'un côté des débutants qui ont moins de deux ans d'expérience, et de l'autre des seniors, avec plus de 10 ans de pratique dans les pattes.

Et ce que cette enquête révèle est complètement contraintuitif.

Ce sont les seniors qui utilisent le plus le code généré par IA dans leur projet.

Par contre, il passe beaucoup plus de temps que les juniors à vérifier en détail le code généré par les assistants.

Ils inspectent, ils le débugnt et ainsi ils se le réapproprient.

En fait, les juniors se reposent sur l'IA comme une béquille, alors que les seniors utilisent l'IA comme une équipe de juniors qui seraient à leur service.

Est-ce que vous voyez la nuance ? Par exemple, avec Antoine.

Un peu plus tôt, je vous ai raconté comment il donnait des directives à son assistant IA, à la façon d'un chef d'orchestre qui dirige ses musiciens à la baguette.

Sauf que le développement, ça n'est pas comme la direction d'orchestre.

C'est plutôt comme la cuisine.

Dans un grand restaurant, le chef étoilé est toujours entouré d'une équipe de cuisiniers très hiérarchisés, qu'on appelle une brigade.

Tout en bas de la hiérarchie, il y a le comit de cuisine, qui en fait ne cuisine pas.

Il épluche les patates ou il nettoie le plan de travail.

Au-dessus, il y a le chef de parti qui ressemble un peu plus à l'idée qu'on se fait de cuisiner.

Il maîtrise la cuisson des aliments, dresses les plats et dirige ses commis d'une main de fer.

Par contre, il est spécialisé, par exemple dans les sauces ou les viandes.

Viens ensuite le sous-chef ou seconde cuisine, c'est le bras droit du chef étoilé.

Il corrige les assaisonnements, il coordonne les différents chefs de parti et s'occupe de la gestion des stocks.

Dans ce contexte très codifié, tout cuisinier qui espère devenir un grand chef étoilé doit commencer sa carrière en bas de l'échelle.

D'abord comit, puis chef de parti et ainsi de suite.

Les outils de développement, comme curseur, copilote et autre clôt de code, sont un peu comme des commis et des chefs de parti.

Ils ont des vraies compétences, mais plus la tâche est complexe, plus il faut quelqu'un pour les encadrer.

On peut dire que coder une page web, c'est comme éplucher les patates.

Produire un site e-commerce de quelques pages avec un panier et un bouton d'achat, c'est comme préparer une viande à la bonne cuisson avec la petite sauce qui va bien.

Et développer une appli qui doit gérer des millions d'utilisateurs en même temps, ça revient à diriger une brigade de 90 personnes pendant le coup de feu.

Et ça, pour l'instant, l'IA en est très loin, étant mieux.

Mais quand Antoine a dû développer l'outil web que je lui avais demandé, il s'est retrouvé à encadrer une brigade de cuisiniers IA sans être préalablement passée par tous les grades.

Là où un développeur sénor, c'est qu'il est comme le chef étoilé. Il est passé par tous les postes de la brigade et si vous lui mettez un flingue sur la temp' il peut émincer les oignons à toute vitesse.

C'est-à-dire pisser du code. Et s'il y a, lui livre un code catastrophique, il va le voir, il va le corriger.

C'est cette polyvalence et cette vision à grande échelle qui manque aux gignores, mais qui permet au sénor de se lâcher sur le code généré par IA.

Les devs séniors, finalement, ils ont respecté le cycle d'apprentissage, théorie, pratique, métacognition.

Et c'est parce que leurs connaissances sont profondément ancrées que l'IA démultiplie leurs compétences au lieu de les atrofier.

Mais du coup, comment on fait pour que les juniors maîtrisent les fondamentaux du code, que les collégiens apprennent leur table des éléments et que les lycéens arrêtent de sous-traiter leur dicère de philo à chat GpT ?

Eh ben, on combat le feu par le feu. Puisque l'IA est omniprésente, autant faire d'elle votre tuteur particulier.

Attention, il s'agit surtout pas de lui demander des réponses toutes prêtes. Ça reviendrait à utiliser l'IA pour du délétage cognitif.

Et c'est précisément ce qu'on cherche à éviter. Alors pour que votre LLM préférée passe en mode tuteur, il faut lui expliquer tout ça.

Lui dire que votre but, c'est d'apprendre une compétence et qu'il doit vous concocter une série d'exercices sans vous donner de suite les réponses.

On a qu'à faire le test justement. Je sais pas vous, mais ça fait très longtemps que j'ai pas fait une division de tête.

Pas un truc évident genre 50 divisé par 2, mais 874 divisé par 26.

Eh ben, si on donne ce prompt à chat GpT, je veux faire un exercice simple et utiliser l'IA comme un mentor, blablabla, donne-moi un exercice.

C'est très intéressant car GpT s'exécute et me demande de calculer 874 par 26, mais ne peut pas s'empêcher et te donner des indices.

On dirait que tels quels, ces IAs sont très orientés vers le délétage cognitif.

Et c'est pas étonnant quand on sait qu'elles sont optimisées pour minimiser l'effort humain.

Mais en le forçant un peu avec des instructions, ça finit par marcher. Rien de plus à toi de jouer.

Ça peut vous paraître un peu gadget d'utiliser chat GpT pour faire des exercices de maths niveau CMA,

sauf que vous pouvez utiliser cette méthode pour des tâches beaucoup plus ambitieuses.

Quand on y pense, c'est une opportunité inédite dans l'histoire de l'humanité.

Pendant des siècles, avoir un professeur particulier était un luxe.

Mais aujourd'hui, avec les bons prompts, vous pouvez transformer votre LLM préféré en précepteur,

comme si vous étiez un aristocrate italien à la Renaissance.

Alors oui, vous n'allez pas pouvoir apprendre l'escalade ou le kitesurf avec chat GpT,

mais pour toutes les compétences qui reposent sur du texte, des calculs ou du code, c'est révolutionnaire.

Le sujet qui fâche, c'est la question de la fiabilité des IAs.

On a vu que leurs principales problèmes, c'était leurs hallucinations.

Pour des raisons structurelles, c'est assez peu probable qu'elles disparaissent totalement.

Mais rien que chez OpenAI, le taux d'allustination a été divisé par 8.

Pour une recherche sur un sujet médical, on est passé de 40% d'allustination chez GPT 3.5 à 5% sur GPT 5.

Et puis la présence d'allustination, c'est peut-être pas si grave.

À partir du moment où les gens le savent, ça les oblige à utiliser leur esprit critique.

Malgré ce potentiel révolutionnaire, il y a encore beaucoup de profs qui sont opposés à la généralisation des tuteurs IA.

Alors, est-ce que cette méfiance est vraiment rationnelle ?

Du côté de la recherche, on commence à avoir des données fascinantes sur l'effet de ces tuteurs.

Des chercheurs d'Arvard ont notamment utilisé GPT 4 pour concevoir un assistant spécialisé dans l'enseignement de la physique, PS2 PAL.

Et c'est directif, inclus le fait de favoriser l'engagement actif des élèves,

de s'adapter à leur charge cognitive et de promouvoir un growth mindset, c'est-à-dire la mentalité de croissance.

Alors, la mentalité de croissance, c'est le fait de ne pas avoir une conception figée de soi-même et de ses compétences.

Souvent, un élève qui ne s'en pas à l'aise avec une matière développe la croyance qu'il n'est pas doué dans cette matière et qui ne peut rien y faire.

C'est ce qu'on appelle le fixed mindset, une vision figée de soi-même délétère pour l'apprentissage.

La mentalité de croissance, au contraire, c'est la certitude qu'on peut progresser malgré les difficultés initiales qu'on rencontre.

Favoriser l'engagement des élèves, s'adapter à leur charge mentale ou favoriser la mentalité de croissance, c'est que les trucs qu'un prof humain peut faire.

Mais là où l'humain atteint sa limite, c'est sur la personnalisation.

Un enseignant doit jongler avec tout un groupe et imposer un rythme unique à sa classe.

Alors que PS2 PAL peut adapter son rythme à chaque élève.

Alors que montrent les résultats de l'étude ? Et bien, ils sont spectaculaires.

Les élèves qui ont bénéficié de PS2 PAL ont fait plus de progrès, plus rapidement et ils étaient plus concentrés pendant les cours.

En fait, les seules dimensions où l'IA est ex-éco avec l'enseignement humain, c'est sur la confiance en soi des élèves et sur le plaisir ressenti pendant les leçons.

On a donc un tuteur IA qui fait aussi bien que les profs, voire mieux, tout en ayant l'avantage de pouvoir gérer un nombre d'élèves illimitées.

Ça ressemble au sein graal de l'enseignement.

Pourtant, ça n'est pas ce que disent les créateurs de PS2 PAL.

En fait, si cette étude a d'aussi bon résultat, c'est grâce à son protocole.

Le modèle est entraîné exprès pour enseigner la mécanique des fluides, avec des promptes complexes rédigées par des profs de physique.

Donc même quand les étudiants sont en tête-à-tête avec le tutoriat, il y a un cadre qui est posé en amont avec une véritable progression pédagogique.

Mais dans les autres études, quand on laisse les élèves apprendre la physique avec un GPT classique sans préparation ni encadrement,

ils mettent systématiquement leur cortex préfrontal sur pause.

Ils copicolent les énoncés, ne vérifient pas les réponses et au final apprennent moins bien qu'avec les enseignants humains.

C'est ça en fait la plus grosse limite des tuteurs IA.

Les utilisés de façon efficace demandent de la volonté, ce qui n'est pas le cas du prof qui impose son autorité aux élèves telle un proxy de l'autodiscipline.

Alors que l'IA, vous pouvez très facilement la manipuler, si celle de votre école est bridée, vous n'êtes qu'à un nouvel onglet, d'en avoir une autre,

et surtout la vraie raison n'est pas technique mais sociale.

Contrairement à votre mentor ou votre prof, vous ne vous sentirez jamais redevable devant elle.

Ça crée un paradoxe catastrophique, parce que sur le papier, les LLM sont des outils parfaitement égalitaires,

que vous soyez le petit-fils de Bernard Arnaud ou la fille d'un immigré ukrainien qui vient d'arriver en France,

si vous avez un smartphone, vous avez accès à un IA.

Sauf que vous aurez constamment deux chemins, celui de la béquille,

qui tend vers la lobotomie du cerveau, et celui du tutor, qui chaque jour vous rendra un peu meilleur.

Le futur risque donc d'être extrêmement inégalitaire.

D'un côté, ceux qui connaissent l'impact de l'IA sur le cerveau,

et prennent la décision de sacrifier l'efficacité pour privilégier leur propre apprentissage.

Et de l'autre, ceux qui s'aident aux sirenes de la gratification immédiate,

mais accumulent les lacunes jusqu'à devenir complètement lobotomisées.

Et ça vaut aussi pour les entreprises d'ailleurs,

celles qui vont privilégier le rendement immédiat au détriment du cerveau de leurs employés,

et celles qui auront une vision long terme.

C'est entendre penser qu'on fera partie des élus, mais le problème, c'est qu'on est très peu à voir de la volonté.

Il suffit de comparer le nombre de gens qui prennent l'ascenseur,

avec ceux qui se forcent à prendre les escaliers.

La team escalier est plutôt minoritaire.

Et c'est normal, parce que la paresse, ça n'est pas un bug, c'est une fonctionnalité.

Des centaines de milliers d'années d'évolution,

ont optimisé notre cerveau pour qu'il soit économique.

C'est pour ça qu'ils prennent des raccourcis dès que possible,

parce que réfléchir, ça consomme de l'oxygène et du glucose.

Le truc, c'est qu'avec Il ya, cette paresse peut prendre une courbe vertigineuse.

On parle plus de stocker de l'info dans des pages Wikipédia,

de troquer notre sens de l'orientation pour un GPS,

ou déléguer des calculs à des fichiers Excel.

Là, on peut sous-traiter le moindre processus mental un peu exigeant,

parce que c'est notre nature profonde de chercher la facilité.

Alors, si on doit lutter contre notre tendance ancestrale à l'appareil,

il faut peut-être chercher la solution dans des vieilles recettes de grand-mère.

À l'école, on dispose déjà d'un système pour forcer les apprenants à faire des efforts.

Ça s'appelle les devoirs sur table.

Attention, les devoirs à l'ancienne, avec juste papier et stylo.

Et un exemple de son utilité, c'est ce qui s'est passé pour le concours de médecine belge de 2025.

En Belgique flamande, il s'est déroulé pour la première fois sur ordinateur.

Résultat, le taux de réussite au concours est étrangement passé de 19% en 2024 à 47%.

Potentiellement des milliers d'apprentis médecins qui ont fraudé.

Mais en Wallonie, ils n'ont pas eu ce problème, parce que le concours se déroule à l'ancienne,

sans support numérique.

Alors au risque de passer pour un boomer, je suis persuadé que les examens avec papier et crayon,

c'est en fait une solution d'avenir.

C'est de la pure manipulation psychologique.

Après une journée de cours, vous avez zéro motivation pour faire vos exos.

Mais si je vous apprends que vous avez un devoir surveillé sans assistance dans 3 jours,

ce futur potentiellement désagréable où vous avez un zéro pointé,

vous donne instantadément la motivation nécessaire.

En tout cas, sur moi, c'est ce qui marche.

J'ai testé d'ailleurs une version radicale de cette solution avec Antoine.

Pendant 3 mois, je lui ai interdit d'utiliser le moindre LLM,

une véritable cure de désintoxication qui a fait chuter sa productivité de façon extrêmement frustrante.

Au départ, tu souffles un peu d'une aie, parce que perdre entre guillemets 2-3 semaines,

c'est pas très satisfaisant, surtout que les résultats, pour moi c'est super important, je suis orienté résultat.

Si on reprend nos 3 piliers de l'apprentissage.

Antoine a été obligé de lire de la documentation avant de commencer à coder,

autrement dit de se bouffer toute la théorie que LIA lui avait jusque là permis d'éviter.

Ensuite, il a dû coder lui-même, c'est-à-dire se confronter à la pratique, au lieu de la sous-traité à LIA,

un véritable exercice de remémoration qui lui a permis d'en créer donc ses connaissances,

et serrer sur le gâteau, chaque fois qu'il était bloqué,

il a dû retourner dans la doc et chercher les bugs ligne par ligne,

ce qui est un vrai exercice de métacognition,

où chaque hypothèse faisait se trémousser ses neurones d'opame énergique.

Après ces 3 mois, on n'a rien introduit LIA petit à petit,

et non seulement Antoine était monté en compétence,

mais en plus, il avait retrouvé du plaisir à coder.

Quand tu commences à embarquer LIA un peu dans ton code, à lui faire écrire une partie du projet,

quand tu reviens chez toi le soir,

tu n'as plus ce truc de j'ai codé telle partie du site,

j'ai codé telle fonctionnalité, j'ai créé ça,

parce que tu ne sais plus à quel point toi t'as créé et LIA a créé.

Tu ne sais pas quelle partie t'appartient encore.

A la limite, tu as presque juste managé NIA en la recadrant de temps en temps,

et finalement, qu'est-ce qui t'appartient encore dans le projet ?

Il y a ce truc de quand c'est toi qui l'as fait,

t'as un énorme plaisir à finalement assembler les pièces du puzzle,

que ton système tourne parfaitement comme tu l'as pensé,

et t'es super fier de l'avoir créé toi,

et t'as qu'une envie, c'est continuer à bosser dessus.

Alors oui, cette histoire de cure de désentox avec Antoine,

ça peut sembler extrême,

mais en fait ça illustre quelque chose de plus profond.

Pendant des millénaires,

l'humanité a progressé en se confrontant à la difficulté.

C'est l'effort qui sculte le cerveau, pas le résultat.

Et là, pour la première fois de notre histoire,

on a un outil capable d'éliminer presque toute friction cognitive.

On aurait pu vous parler des autres menaces,

l'empreinte carbone des datacenters,

le pillage de la propriété intellectuelle,

la souveraineté numérique ou les métiers qui disparaissent,

tout ça est réel,

mais on a choisi de se concentrer sur le cerveau,

parce que le cerveau, c'est la racine.

Une société qui ne s'est plus formée ses enfants à penser,

elle peut avoir toutes les lois,

tous les brevets et toutes les éoliennes du monde,

elle sait fondre quand même.

L'éducation, c'est pas un secteur parmi d'autres,

c'est le socle,

c'est là qu'on fabrique ceux qui vont hériter de tout le reste.

Donc non, Lianne va pas nous rendre stupide.

On va se rendre stupide tout seul,

si on choisit systématiquement le chemin le plus court.

La bonne nouvelle, c'est que c'est un choix.

Et comme tous les choix,

il se fait chaque jour, à chaque prompte,

utiliser l'IA comme une béquille

ou comme un sparing partner,

déléguer sa pensée

ou l'aiguiser.

Au fond, la question n'a jamais été de savoir

si Tchia GPT était intelligent,

c'est de savoir si nous,

on veut encore le rester.

Sous-titres réalisés par la communauté d'Amara.org

On est la team de 4 quart d'heure.

Le podcast qui dure, 4 quart d'heure.

On fait partie de la sélection à Castre Command.

Dans notre podcast, on partage nos ups et nos downs toutes les semaines.

L'occasion de vous raconter tout ce qu'on déteste.

Comme les cyclistes qui s'arrêtent pas au passage piéton, par exemple.

Mais aussi, ce qu'on aime d'amour.

Comme le cinéma, l'intelligence émotionnelle et les bons chiens.

Oui, les bons chiens.

Si, vas-y, ça regarde.

Si tu veux rejoindre les Intelo Relax,

c'est les plus sexistes de ta région.

Écoute-nous tous les mardi sur ton appui de podcast préféré.

La prouesse robotique derrière la livraison en 24h — Renaud Heitz (rediff)

La prouesse robotique derrière la livraison en 24h — Renaud Heitz (rediff)